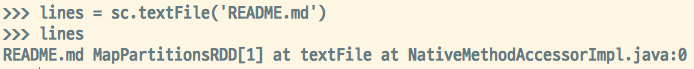

요즘은 팀에 들어온 일이 빅데이터 관련이라 그런쪽만 한다. 스파크를 많이 만지는데, 솔직히 일 하기전에는 이런 빅데이터 관련 직업을 잡으려면 기본 석사에 박사까지 해야지 이런거 할수있다.. 고 들은것같다. 그런데 지금 와서 우연히 팀을 잘 선택해서? 이런 일을 하고있는거 보니 사람일은 모르는것 같다. 스파크라는 걸 회사와서 처음 해보는건데 재미있다. 개발을 하면서 다시느끼는건데 파이썬은 진짜 엄청나게 범용적인것 같다. 항상 어디 처음보는 언어나 프레임워크도 지원하고, 이 스파크도 스칼라와 자바, 파이썬을 지원한다. 어쨋든 파이썬을 너무너무 좋아하는 나로서는 뭔가 기본 베이스가 되니까 쉽다. 기본적인 함수는 거의 다 같다고 보면 되고 그냥 뒤로 붙이기만 하면 된다.사실 처음이라 아무것도 모르고 그냥 함수 ..